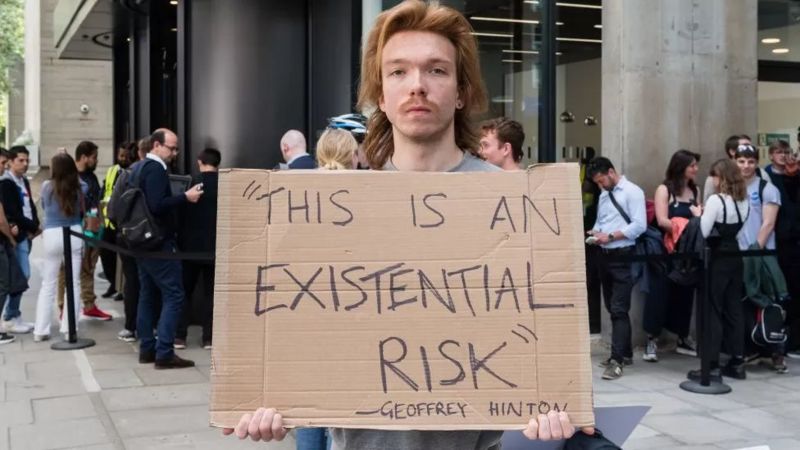

“कृत्रिम बौद्धिकताबाट मानव अस्तित्व जोखिममा पर्न सक्छ।” धेरै विज्ञहरूले यसबारे चेतावनी दिएका छन्। यस्तो चेतावनी दिनेहरूमा ओपनएआई र गुगल डिपमाइन्डका प्रमुखहरू समावेश छन्।

यस सम्बन्धमा जारी विज्ञप्ति ‘सेन्टर फर एआई सेफ्टी’ को वेबपेजमा प्रकाशित गरिएको छ । यस भनाइसँग धेरै विज्ञहरूले आफ्नो सहमति व्यक्त गरेका छन्।

विज्ञहरूले चेतावनी दिँदै भनेका छन्, “समाजलाई प्रभावित गर्न सक्ने अन्य खतराहरु जस्तै महामारी र आणविक युद्धका साथसाथ एआई (कृत्रिम बौद्धिकता) ले उत्पन्न गरेको अस्तित्वको खतरालाई न्यूनीकरण गर्नु विश्वव्यापी प्राथमिकता हुनुपर्छ।”

तर यसको डरलाई बढाइचढाइ गरिँदै आएको धेरैको धारणा छ ।

च्याटजीपीटीका प्रमुख कार्यकारी सैम अल्टम्यान, गुगल डीपमाइन्डका प्रमुख कार्यकारी डेमिस हासाबिस र एन्थ्रोपिकका डारियो अमोदेईले उक्त कथनलाई समर्थन गरेका छन्।

के हुन सक्छन् खतराहरु

सेन्टर फर एआई सेफ्टी वेबसाइटले प्रकोपका लागि धेरै सम्भावित परिदृश्यहरू सूचीबद्ध गरेको छ।

एआईलाई हतियारको रूपमा प्रयोग गर्न सकिन्छ । उदाहरणका लागि, रासायनिक हतियार बनाउन औषधि खोज उपकरणहरू प्रयोग गर्न सकिन्छ।

एआई–उत्पन्न गलत सूचनाले समाजलाई अस्थिर बनाउन सक्छ र ‘सामूहिक निर्णयलाई प्रभाव पार्न सक्छ’।

‘सरकारहरूलाई यसलाई सामूहिक निगरानी र दमनकारी सेन्सरशिपको लागि प्रयोग गर्न’ अनुमति दिँदै एआईको शक्ति केही हातहरूमा केन्द्रित हुन सक्छ ।

फिल्म ‘भोल ई’ मा देखाइएजस्तै मानिस एआईमा निर्भर हुँदा यस्तो अवस्था पनि सिर्जना हुन सक्छ ।

के खतरा बढाइचढाइ भइरहेको छ ?

एआई सुरक्षा केन्द्रको चेतावनीलाई डा जेफ्री हिन्टनले पनिसमर्थन गरेका छन्। उनले पहिले नै सुपर इन्टेलिजेन्ट एआईको खतराबारे चेतावनी जारी गरिसकेका छन्

युनिभर्सिटी अफ मोन्ट्रियलका कम्प्युटर साइन्सका प्रोफेसर योशुआ बेन्जोले पनि विज्ञप्तिमा हस्ताक्षर गरेका छन् ।

यो क्षेत्रमा डा हिन्टन, प्रोफेसर बेन्जो र प्रोफेसर यान लाकेनको उल्लेखनीय कामका कारण उनीहरुलाई ‘एआईको गॉडफादर’ भनिन्छ।

यसका लागि उनीहरुलाई सन् २०१८ मा संयुक्त रुपमा ‘टर्निङ अवार्ड’ प्रदान गरिएको थियो । कम्प्युटर विज्ञानको क्षेत्रमा उल्लेखनीय योगदान पुर्याएबापत यो अवार्ड प्रदान गरिन्छ ।

प्रोफेसर लाकेन पनि मेटाका लागि काम गर्दछन्। उनका अनुसार सर्वनाशसँग सम्बन्धित यो चेतावनी बढाइचढाइ गरिएको छ।

उनले ट्विट गरेका छन्, “विनाशका यी भविष्यवाणीहरूमा एआई अनुसन्धानकर्ताहरूको सबैभन्दा सामान्य प्रतिक्रिया अनुहारमा हत्केला राख्नु हो।”

अरु धेरै विज्ञहरुको राय पनि यस्तै छ । उनीहरुका अनुसार एआईले मानवतालाई नष्ट गर्नेछ, यो डर वास्तविक होइन। यी कुराहरूले प्रणालीमा पूर्व–अवस्थित पूर्वाग्रह जस्ता समस्याहरूबाट ध्यान हटाउन सक्छ।

प्रिन्सटन युनिभर्सिटीका कम्प्युटर वैज्ञानिक अरविन्द नारायणनले यो साइ–फाई घटना वास्तविक होइन भनेका छन् ।

उनका अनुसार वर्तमान एआईसँग त्यस्ता जोखिमहरूलाई वास्तविकतामा अनुवाद गर्ने क्षमता छैन। नतिजाको रूपमा यो अवस्थाले एआईले हुनसक्ने हानिबाट ध्यान हटाउँदैछ।

अक्सफोर्ड इन्स्टिच्युट फर एथिक्स इन एआईका वरिष्ठ अनुसन्धान सहयोगी एलिजाबेथ रेनिरीस भन्छिन्, “म वर्तमानको तुलनामा निकट अवधिका खतराहरूबारे बढी चिन्तित छु ।”

“एआईमा भएको प्रगतिले पक्षपाती, भेदभावपूर्ण, अलग्गै र निष्पक्ष हुने स्वचालित निर्णयहरूको सम्भावना बढाउनेछ। तिनीहरूको समीक्षा र कार्यान्वयन गर्न सकिँदैन, त्यहाँ कुनै बहस हुनेछैन”, उनी भन्छिन् ।

उनका अनुसार यसले भोल्युम र गलत सूचनाको फैलावटमा घातीय वृद्धि निम्त्याउनेछ। यसले वास्तविकतालाई सही रूपमा प्रतिबिम्बित गर्दैन। यसले जनताको विश्वासलाई कमजोर बनाउँछ। यसले असमानतालाई अझ बढाउँछ। विशेष गरी डिजिटल रुपमा विभाजित संसारको कमजोर पक्षमा रहेकाहरूका लागि।

के हो सुरक्षित तरिका ?

रेनिरीसका अनुसार एआईका धेरै उपकरणहरू अहिलेसम्म मानव अनुभवमा निःशुल्क सवारी जस्तै छन्। यी धेरैजसो प्रशिक्षणहरू मानव निर्मित सामग्री, पाठ, कला र संगीतमार्फत भएका छन्। त्यही आधारमा काम गर्छन् ।

तिनीहरूलाई तयार गर्नेहरूले सामान्य जनताबाट सबै सम्पत्ति र शक्तिलाई प्रभावकारी रूपमा केही निजी संस्थाहरूमा फर्काए।

तर सेन्टर फर सेफ्टीका निर्देशक दत्तन हेन्ड्रिक्सले बीबीसीलाई भनेका छन्, “आगामी जोखिम र आजको चिन्तालाई द्वन्द्वात्मक रूपमा हेर्नु हुँदैन।”

उनका अनुसार आज केही समस्या समाधान भयो भने अगाडि आउने धेरै जोखिमलाई समाधान गर्न मद्दत पुग्छ ।

चिन्ता नयाँ होइन

यो एआईमार्फत अस्तित्वमा सम्भावित खतराको सन्दर्भमा सन् २०२३ मार्चदेखि बढेको छ। त्यसपछि टेस्लाका मालिक एलोन मस्कलगायत धेरै विज्ञहरूले खुला पत्र लेखे। यसमा एआई प्रविधिको अर्को पुस्ताको विकास रोक्न अनुरोध गरिएको थियो ।

पत्रमा सोधिएको थियो, “के हामीले गैर–मानव मस्तिष्क बनाउनु पर्छ जसले अन्ततः हामी भन्दा धेरै होशियार हुनेछ र हामीलाई प्रतिस्थापन गर्नेछ ?”

यसबाहेक नयाँ अभियानअन्तर्गत एकदमै सानो वक्तव्य जारी गरिएको छ । यसमा ‘चर्चा सुरु गर्ने’ कुरा छ ।

उक्त वक्तव्यमा खतरालाई आणविक युद्धसँग तुलना गरिएको छ। ओपनएआईले भर्खरै गरेको ब्लगले सुपरइन्टेलिजेन्सलाई आणविक ऊर्जा जस्तै नियन्त्रण गर्नुपर्दछ भनी बताउँछ।

ब्लगमा लेखिएको छ, “सुपरइन्टेलिजेन्सका लागि हामीलाई आईएईइ (अन्तर्राष्ट्रिय आणविक ऊर्जा एजेन्सी) जस्तो संस्था चाहिन्छ।

सुनकले दिए आश्वासन

साम अल्टम्यान र गुगलका प्रमुख कार्यकारी सुन्दर पिचाई प्राविधिक क्षेत्रका प्रमुख व्यक्तित्वहरू हुन् जसले भर्खरै बेलायतका प्रधानमन्त्री ऋषि सुनकसँग एआई कसरी नियन्त्रण गर्ने भन्ने बारेमा कुरा गरेका छन्।

एआईको खतराहरू बारे भर्खरैको चेतावनीको बारेमा पत्रकारहरूसँग कुरा गर्दै, सुनकले यसले अर्थतन्त्र र समाजमा ल्याउन सक्ने फाइदाहरूमा जोड दिए।

उनले भने, “तपाईंले भर्खरै हेर्नुभयो कि यसले पक्षाघात भएका मानिसहरूलाई हिँड्न मद्दत गरिरहेको छ। नयाँ एन्टिबायोटिकहरू पत्ता लागिरहेका छन् तर हामीले यो सबै सुरक्षित तरिकाले गर्ने निर्णय गर्नुपर्छ।”

“त्यसैले मैले गत हप्ता सबै प्रमुख एआई कम्पनीका सीईओहरूसँग भेट गरेँ कि हामीले कुन अवरोधहरू राख्न आवश्यक छ, हामीले के नियन्त्रणहरू राख्नु पर्छ ताकि हामी सुरक्षित हुन सक्छौं”, उनले भने।

बेलायतका प्रधानमन्त्री सुनकले जी७ शिखर सम्मेलनमा अन्य नेताहरूसँग यस विषयमा छलफल गरेको र छिट्टै अमेरिकामा पनि यो विषय उठाउने बताएका छन् । जी७ठ ले हालै एआईका लागि ‘कार्यकारी’ समूह गठन गरेको छ।

बीबीसी